Claude 3: Ist dieses neue KI-Modell eine Bedrohung für GPT-4?

Anthropic hat gestern Claude 3 vorgestellt, eine neue Familie von KI-Modellen, die in der Branche für Aufsehen sorgt.

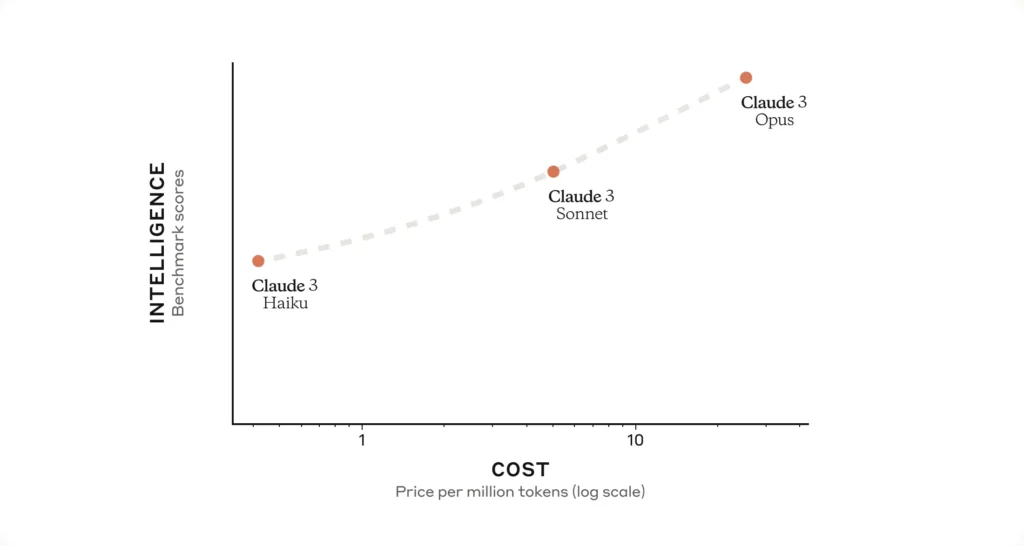

Diese Modelle, benannt als Claude 3 Haiku, Claude 3 Sonnet und Claude 3 Opus, haben unterschiedliche Fähigkeiten.

Das ermöglicht es Nutzern, genau das Modell auszuwählen, das am besten zu ihren Bedürfnissen passt – sei es in puncto Schnelligkeit, Intelligenz oder Preis.

Hier ist eine Aufschlüsselung der Claude 3 KI-Modelle nach ihrem Namen und den jeweiligen Fähigkeiten:

- Haiku: Schnellste Antwortzeiten und höchste Kosteneffizienz, ideal für einfache Anfragen und schnelle Interaktionen.

- Sonnet: Bietet ein Gleichgewicht zwischen Geschwindigkeit und Intelligenz, optimiert für Unternehmensanwendungen und vielseitige Aufgaben.

- Opus: Das leistungsfähigste Modell mit umfassenden kognitiven Fähigkeiten, ausgelegt für komplexe Analysen und tiefgehendes Verständnis.

Technologische Fortschritte und Verfügbarkeit

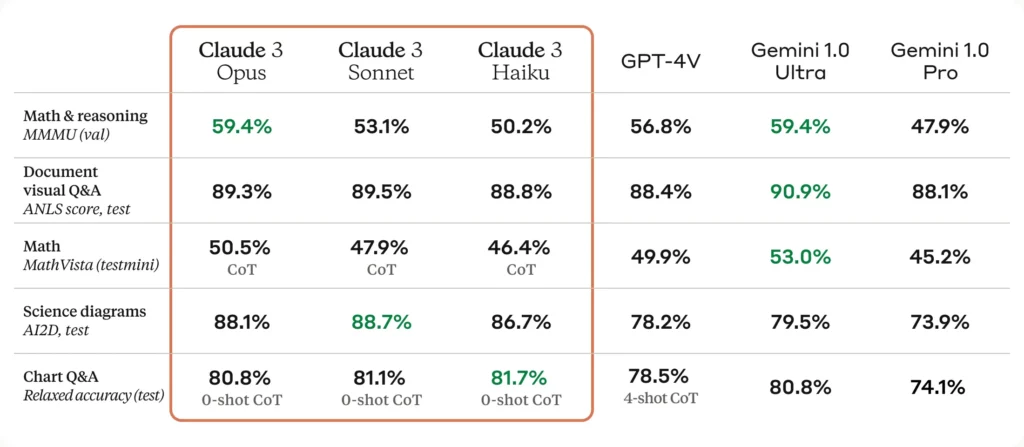

Claude 3 stellt einen Fortschritt in verschiedenen kognitiven Bereichen dar, darunter Analyse, Prognose, Content-Erstellung und mehrsprachige Konversationen.

Opus, das Spitzenmodell, übertrifft bestehende Benchmarks und zeigt beeindruckende Leistungen in der allgemeinen Intelligenz.

Die Modelle bieten auch in Echtzeitanwendungen wie Live-Chats und Datenerfassungsaufgaben eine bemerkenswerte Performance, wobei Haiku besonders durch seine Geschwindigkeit und Kosteneffizienz hervorsticht.

Ein interessanter Aspekt der neuen Modelle ist ihre Fähigkeit, visuelle Inhalte zu verarbeiten, was sie für Unternehmen mit umfangreichen visuellen Wissensdatenbanken attraktiv macht.

Die Verbesserung der Modellgenauigkeit und die Reduzierung unnötiger Verweigerungen sind weitere wichtige Fortschritte, die die Nutzerfreundlichkeit und Effizienz der KI-Modelle erhöhen.

Verantwortung und Sicherheit in der Entwicklung

Anthropic unterstreicht die Bedeutung verantwortungsvoller KI-Entwicklung und die Notwendigkeit, Sicherheits- und Transparenzstandards zu verbessern.

Die Modelle wurden mit Blick auf die Minimierung von Risiken wie Fehlinformationen oder Datenschutzproblemen entwickelt. Die Bemühungen, Bias zu reduzieren und eine neutralere Modellierung zu fördern, zeigen das Bestreben, ethische Bedenken im KI-Bereich anzugehen.

Wie geht Anthropic mit potenziellen Sicherheitsbedenken und Verzerrungen in ihren Modellen um?

Anthropic setzt die Technik der ‘Constitutional AI’ ein, die den Modellen eine Art ‘Verfassung’ für den Umgang mit heiklen Fragen mitgibt. Sicherheit und Vertrauenswürdigkeit haben für das Unternehmen höchste Priorität.

In welchen Branchen setzen Kunden bereits Anthropics KI-Modelle ein?

Kunden aus Finanzdienstleistungen, Telekommunikation, Bildung, Gesundheitswesen und Nonprofit-Organisationen setzen die KI-Modelle von Anthropic bereits ein, darunter namhafte Unternehmen wie Bridgewater, SAP und das Dana-Farber Cancer Institute

Fazit:

Mit der Einführung von Claude 3 zeigt Anthropic, dass die Entwicklung von KI-Modellen weiterhin rasante Fortschritte macht, wobei die Betonung auf Leistung, Sicherheit und ethischer Verantwortung liegt. Diese Modelle könnten in vielerlei Hinsicht die Landschaft der KI-Anwendung und -Forschung prägen.